ENSAYOS CLÍNICOS

Investigaciones

۞La medicina basada en la evidencia está en crisis porque la información patrocinada por la industria es incompleta y está sesgada. (How evidence-based medicine is failing due to biased trials and selective publication).

Every-Palmer S1, Howick J

J Eval Clin Pract 2014, May 12. doi: 10.1111/jep.12147

Traducido por Salud y Fármacos

La medicina basada en la evidencia (MBE) se define como el uso consciente y juicioso de la mejor evidencia para, teniendo en cuenta la experiencia clínica y los valores del paciente, tomar las decisiones terapéuticas [1,2].

Lo que podría constituir “mejor evidencia” se categoriza en niveles, como la escala producida por el Centro de Oxford para la MBE [3]. En la mayoría de los sistemas de clasificación, las revisiones sistemáticas de ensayos clínicos aleatorizados se colocan en el vértice de la pirámide y los razonamientos clínicos y las “opiniones de expertos” en la parte inferior. Es irónico que, aunque existen buenas razones para pensar en que la MBE debe beneficiar a la población, no hay evidencia empírica de “alta calidad” (de acuerdo a los estándares de MBE) de que efectivamente lo haga. En este sentido, poco ha cambiado desde que el “Users Guide to Evidence-Based Medicine” se publicó por primera vez en 1992:

“Nuestra defensa de la MBE ante la ausencia de pruebas definitivas sobre su superioridad en promover la salud del paciente puede parecer una contradicción interna. Cuando la evidencia definitiva no está disponible, se debe recurrir a pruebas más débiles… y a la racionalidad biológica. La racionalidad en este caso es que los médicos que leen críticamente la literatura están más actualizados distinguen entre evidencias fuertes y débiles y tienden a ser más juiciosos en la terapia que recomiendan… [y] hacen diagnósticos más precisos”[4].

Los autores llegaron a sugerir que “hasta que se aportasen pruebas más definitivas” el recurso a la MBE debería “restringirse” a tres grupos de profesionales: los que consideren que hay una justificación convincente, los que la utilicen para ensayos clínicos educativos y los que piensen que “la práctica de la medicina en el nuevo paradigma es más emocionante y divertida” [4]. El primer grupo era grande y en la década de 2000 el movimiento de la MBE ya se describía como una “revolución” [5,6] y en el 2001 la revista Time dijo que era una de las ideas contemporáneas más influyentes [7]. La carrera de la MBE hasta convertirse en el paradigma médico imperante puede considerarse como “meteórica” [8].

La MBE ha demostrado mejorar la práctica en áreas específicas. Por ejemplo, al tener mejor evidencia sobre la efectividad de los tratamientos, se ha mejorado la atención de pacientes que han sufrido un accidente cerebrovascular o un infarto de miocardio [9,10] y algunas prácticas nocivas se redujeron cuando los ensayos revelaron que los riesgos superan los beneficios (por ejemplo, la terapia de reemplazo hormonal después de la menopausia) [11,12]. Estos ejemplos son prometedores, pero anecdóticos. En otro ejemplo, un estudio que comparaba la capacidad de los médicos entrenados en MBE en la Universidad de McMaster con la de compañeros que recibieron la formación habitual se encontró que, a los cinco años de haberse graduado, los primeros conocían mejor las guías de la hipertensión [13].

Sin embargo, este resultado se refiere a una variable subrogada. ¿Cómo podemos saber que un mejor conocimiento de las guías se traduce en mejores resultados para los pacientes? ¿O que el tiempo empleado en el aprendizaje de la evaluación crítica ha impedido que otros temas importantes del currículo se discutieran? También podría ser que los graduados de McMaster sobresalieran en el tratamiento de la hipertensión pero tuvieran problemas de conocimiento sobre la meningitis pediátrica.

Si la MBE fuera ese aclamado movimiento revolucionario deberíamos tener evidencia de sus beneficios, más allá de unos casos específicos. Esperaríamos ver ganancias en el nivel de salud de la población semejantes a las que se produjeron después del descubrimiento de los antibióticos, la mejora de los sistemas de saneamiento o el abandono del tabaco [14]. Desafortunadamente, hay poca evidencia de que la MBE haya tenido tales efectos.

No es fácil que se realice un ensayo aleatorizado a nivel poblacional para responder a la pregunta sobre la efectividad de la MBE, porque se tendrían que superar una serie de retos metodológicos difíciles como el tamaño de la muestra, la contaminación, el cegamiento, el seguimiento y las medidas de resultado.

A nivel macro, tenemos evidencia de que el costo de la atención de la salud sigue aumentando [15], de que las mejoras a la salud están en fase de estancamiento (por ejemplo http://www.mortality-trends.org) y que la confianza en los profesionales médicos está disminuyendo [16]. Dado que la MBE privilegia el enfoque empírico sobre la opinión de expertos o el razonamiento mecanicista, resulta irónico que su aceptación generalizada se haya basado en la opinión de expertos y en razonamientos mecanicistas, en lugar de en “evidencia sólida” de que la MBE realmente funciona.

¿Han sido los ensayos clínicos financiados por la industria los que han perjudicado el desarrollo de la MBE?

Hay varias formas de explicar porque no hay datos que demuestren que la MBE se ha traducido en verdaderas mejoras en los cuidados de salud. Puede ser que nos estemos acercando a los límites de la medicina, de manera que las mejoras son cada vez más difíciles de conseguir. Desde este punto de vista, la fruta madura ya se habría recogido (como los notables triunfos sobre enfermedades infecciosas), y las restantes enfermedades crónicas complejas (como la enfermedad mental, la diabetes, enfermedades del corazón, el cáncer o el Alzheimer) son simplemente más difíciles de abordar. De ser este el caso, es difícil justificar el gasto de recursos en estrategias cuyos efectos no podemos medir.

Otra posibilidad es que la filosofía de la MBE tenga algún problema inherente que impida que su implementación se traduzca en beneficios para la salud. Esto sigue siendo posible, aunque uno de nosotros (JH) ha publicado una extensa defensa de la filosofía de la MBE [17] que aborda esta preocupación.

La hipótesis no exclusiva que exploraremos en detalle es que la falta de evidencia de que la MBE ha tenido un beneficio global se debe a que la MBE no se ha implementado de manera efectiva. En concreto, vamos a argumentar que un aspecto clave de la metodología MBE -el ensayo clínico aleatorizado- se ha visto con frecuencia corrompido por los intereses que intervienen en la elección de las hipótesis de los ensayos, su diseño e implementación y en la presentación selectiva de sus resultados. Vamos a apoyar nuestro argumento con ejemplos de psiquiatría, donde los problemas de corrupción de los ensayos aleatorios son dramáticos.

Ejemplos clínicos: ¿Prescripción de antipsicóticos y antidepresivos de acuerdo con la evidencia?

Los trastornos psicóticos, como la esquizofrenia, afectan a 24 millones de personas en todo el mundo [18] y son condiciones gravemente debilitantes. Los antipsicóticos son un gran negocio y en este momento, en EE UU, es la clase de medicamentos con mayor volumen de ventas. Su mercado internacional en el 2010 se estima que fue de US$19.600 millones [19].

La depresión es la tercera causa de discapacidad en todo el mundo [20]. El mercado mundial de los antidepresivos fue valorado en US$11.900 millones en 2011, con tasas de crecimiento anual del 1,7 %, que se prevé que continuarán en el futuro [21].

Estas son enfermedades importantes a las que se ha dedicado mucha investigación (y dinero) con el objetivo de desarrollar prácticas de manejo basadas en la evidencia. Vamos a considerar las perspectivas predominantes para el tratamiento de la psicosis y la depresión en la década de 1990 a 2000.

Psicosis. Hay dos categorías de medicamentos que se utilizan para el tratamiento de la psicosis: la primera generación de antipsicóticos o también llamados antipsicóticos “típicos” desarrollados en la década de 1960 (por ejemplo, la perfenazina, el haloperidol, la clorpromazina) y la segunda generación o antipsicóticos “atípicos” que se desarrolló en la década de los 90s (por ejemplo, la olanzapina, la quetiapina o la risperidona). Los antipsicóticos típicos son de bajo costo. A lo largo de la década de los 90s los antipsicóticos atípicos permanecieron bajo la protección de patentes y eran caros.

Tras la introducción de los antipsicóticos atípicos se publicaron muchos ensayos y revisiones de alta calidad que determinaron que eran mejor tolerados y más eficaces que sus predecesores. Tener “tratamientos efectivos” cambió la demografía de algunos diagnósticos. Al “probarse” que los atípicos eran eficaces para la enfermedad bipolar, las tasas de diagnóstico aumentaron dramáticamente, especialmente en niños. De hecho, el número de niños y adolescentes tratados para el trastorno bipolar en los EE UU aumentó 40 veces entre 1994 y 2000 [22].

En la práctica de uno de los autores (SE-P), a mediados de la década del 2000, todos los pacientes psicóticos recibían prescripciones con antipsicóticos atípicos. Aunque en ese momento los atípicos costaban aproximadamente US$4.000 más por paciente y año que los típicos [23], la “evidencia más robusta” justificaba esta diferencia de precio. Estábamos favoreciendo a los atípicos después de haber valorado la evidencia y las guías clínicas. Y no estábamos solos. Más del 90% de las prescripciones de antipsicóticos eran de atípicos [24].

Depresión. Los inhibidores de la recaptación de la serotonina (ISRS) también se desarrollaron en la época de la MBE. Antes de la llegada de los ISRS, los antidepresivos tricíclicos eran la base del tratamiento farmacológico para la depresión, pero durante la década de los 90s los ISRS, que son más caros, se comercializaron agresivamente como más seguros, eficaces y bien tolerados; y esto parecía venir respaldado por la evidencia. Pocos medicamentos se han utilizado en tantos ensayos clínicos de doble ciego, controlados con placebo, para demostrar su eficacia y conseguir el permiso de comercialización como los ISRS. Se han realizado más de mil ensayos aleatorios con antidepresivos [25] y repetidamente han mostrado aportar beneficios estadísticamente significativos. Esta enorme cantidad de evidencia tranquilizó a los médicos y a los pacientes, y los ISRS como el Prozac (fluoxetina) se convirtieron rápidamente en medicamentos superventas (blockbuster), suplantando a otros antidepresivos y tratamientos psicológicos (como la terapia cognitivo-conductual) más comúnmente recomendados para la depresión. Su uso se ha extendido tanto que uno de cada 10 estadounidenses mayores de 12 años toma antidepresivos, y son la clase de medicamentos más frecuentemente utilizada por los adultos jóvenes y de mediana edad [26].

¿Una historia de éxito clínico y una victoria de la MBE? Lo que hasta ahora hemos relatado sugiere que ha habido una mejora de los resultados en los pacientes y que la MBE es capaz de identificar tratamientos superiores para reemplazar alternativas menos eficaces. Sin embargo, la realidad es diferente. Diez años después de que los antipsicóticos atípicos hubieran saturado el mercado, grandes ensayos clínicos realizados por grupos independientes, conocidos por las siglas del CATIE (Clinical Antipsychotic Trials of Intervention Effectiveness), CUtLASS (Cost Utility of the Latest Antipsychotic Drugs in Schizophrenia Study) y EUFEST (European First Episode Study) han demostrado que los antipsicóticos atípicos no son ni más eficaces, ni están mejor tolerados y son mucho menos costo efectivos que sus predecesores [23, 27-29].

En relación a la depresión, meta-análisis independientes que incluyeron tanto datos publicados como inéditos, muestran que los ISRS no son más efectivos que el placebo en el tratamiento de la depresión leve a moderada, los problemas para los que han sido más comúnmente prescritos [30, 31].

Así que ¿Cómo es que durante más de una década hemos estado convencidos de que estos tratamientos eran superiores? ¿Cómo ha podido “construirse un mito a partir de la evidencia de mil ensayos clínicos aleatorios” [25] y ¿Cómo nos dejamos embaucar?

¿Qué salió mal con los ensayos aleatorios?

Parece que hay algo en la forma en que los ensayos clínicos aleatorios (ECAs) se realizan en el mundo real que ha socavado su fiabilidad. Exploraremos este tema preguntándonos:

1) ¿Quién financia los ensayos aleatorios? ¿Es importante saber quién lo hace? En primer lugar, está claro que la mayor parte de la evidencia médica existente ha sido financiada por la industria, aunque a menudo estas relaciones financieras no se han revelado. Entre dos tercios y tres cuartas partes de todos los ensayos aleatorios publicados en las principales revistas han sido financiados por la industria [32, 33].

En segundo lugar, existen pruebas contundentes de que los estudios financiados por la industria producen resultados que difieren de los estudios financiados por organismos independientes. Comparado con los ensayos financiados por organismos independientes, los ensayos patrocinados por la industria exageran los efectos positivos del tratamiento fabricado por su patrocinador [34-37].

La influencia de la industria ha sido generalizada en toda la medicina, y la psiquiatría ha estado en el epicentro de gran parte de la controversia sobre el sesgo de la fuente de financiación y el conflicto de intereses (por ejemplo, [38-40]). Entre los estudios aleatorizados, doble ciego, controlados con placebo publicados en las revistas psiquiátricas, las que informaron de conflictos de interés fueron cinco veces más propensas a mostrar resultados positivos [33].

Heres et al. revisaron los ensayos clínicos financiados por la industria que comparaban la eficacia de antipsicóticos atípicos para determinar si existía una relación entre el patrocinador y el resultado del estudio [41]. Y así fue, el 90% de los ensayos mostraron la superioridad del fármaco del patrocinador. La circularidad resultante se refleja en el título del estudio “¿Por qué es mejor la olanzapina que la risperidona, la risperidona que la quetiapina y la quetiapina que la olanzapina?”, en los ensayos que compararon las mismas drogas, el medicamento fabricado por el patrocinador casi siempre resulto ser superior. Este resultado, no plausible, no se debe a un sesgo de publicación. Los estudios habían sido diseñados de forma que prácticamente se garantizara que el fármaco del patrocinador sería el “ganador”, por ejemplo, porque la dosis del fármaco de comparación era demasiado baja para ser efectiva o al contrario, la dosis era tan alta que produciría efectos secundarios intolerables. La exclusión o la inclusión de pacientes específicos, los periodos de tratamiento con placebo, un corto periodo de seguimiento, la selección de las técnicas de imputación, el uso (o no) de ajustes y la producción de informes parciales de resultados son técnicas que se utilizan para magnificar la estimación del tamaño del efecto. Smith [42] resume algunos de estos efectos en el cuadro 1.

Otra información de cómo se sesgan los datos proviene de los juicios contra las empresas farmacéuticas. En 2012 GlaxoSmithKline (GSK) recibió una multa récord de US$3.000 millones por varios delitos penales y civiles, incluyendo la promoción ilegal de medicamentos, el no informar sobre datos de seguridad y por diseminar información falsa [43]. Esto incluye la creación de “artículos deliberadamente sesgados” que afirmaban falsamente que la paroxetina (un ISRS) era eficaz en menos de 18 segundos y la no divulgación de los ensayos con resultados negativos. De hecho no había evidencia de que la paroxetina fuese eficaz en los adolescentes y sí de que acarreaba un pequeño pero real riesgo de suicidio [44]. GSK también fue acusado de crear “consejos de asesores falsos y programas de formación médica continuada supuestamente independientes” [45].

Cuadro 1. Ejemplos de los métodos que utiliza la industria farmacéutica para obtener los resultados que quiere de los ensayos clínicos, Smith 2005 [42]

El caso de GSK no es atípico. Johnson & Johnson, fabricante de los antipsicóticos atípicos risperidona y paliperidona, se ha declarado culpable de crimen menor por la propaganda de la risperidona [46]. La empresa recibió US$2.200 millones en multas civiles y penales en el año 2013 y US$1.200 millones en 2012 por prácticas engañosas, incluyendo ocultación de riesgos y exageración de beneficios [45, 47]. En el año 2009, Eli Lilly, pagó un acuerdo extrajudicial de US$1.400 millones por comercialización ilegal y por ocultar los riesgos de la olanzapina. En el año 2010 AstraZeneca pagó US$520.000.000 para resolver acusaciones en relación con la comercialización ilegal de la quetiapina (también un atípico) y por ocultar sus efectos adversos. Los documentos que se publicaron a raíz del juicio proporcionan información interesante. Los correos electrónicos muestran como un alto ejecutivo de la empresa hablaba sobre las estrategias que podrían dar “un giro positivo en este estudio maldito”. “Lisa [médico de la compañía] ha conseguido esconder la verdad” dice con aprobación. “Hasta ahora, hemos enterrado los ensayos 15, 31 y 56″, escribió un gerente de publicaciones. “El problema más grande es cómo nos enfrentaremos al mundo exterior cuando empiecen a criticarnos por ocultar datos” [48].

2) ¿Cómo se seleccionan los ensayos aleatorios y qué preguntas se quieren responder? Al igual que cuando se presentan resultados sesgados, la selección del tratamiento que se va a testar y las preguntas que se intentan responder vienen determinadas por lo que probablemente será rentable y lo que beneficiará más a los pacientes. El problema es que a veces lo que es mejor para los pacientes va en contra de lo que es económicamente más rentable.

Aunque el número de ensayos aleatorios está aumentando exponencialmente, la cantidad de evidencia disponible sobre una intervención o práctica tiende a estar mejor correlacionada con el interés comercial que con la importancia clínica de la intervención. Es decir, los ensayos aleatorios son caros, por lo que los estudios financiados por la industria se centran en los tratamientos potencialmente más lucrativos [49], como los medicamentos nuevos, los protegidos por patente, los de alto costo o los medicamentos considerados con gran potencial comercial. En comparación con el gran número de ensayos clínicos de tratamientos farmacológicos (patentables) para la depresión, ha habido muy pocos ensayos clínicos sobre el papel del ejercicio físico en la depresión, una intervención que según una revisión Cochrane podría tener una eficacia equivalente al tratamiento farmacológico convencional [50]. Hasta qué punto el ejercicio es útil para tratar la depresión es una pregunta de gran relevancia clínica pero no tiene valor comercial, porque el ejercicio no puede ser patentado.

Por el contrario, muchas preguntas clínicamente sin importancia (o preguntas suficientemente estudiadas) se estudian hasta la saciedad mientras que las cuestiones importantes se descuidan. Por ejemplo, miles de ensayos aleatorios comparan la eficacia de antipsicóticos similares y ninguno investiga tratamientos efectivos para el estreñimiento que causan los antipsicóticos, un efecto adverso angustiante que ocurre hasta en el 60 % de los pacientes tratados con estos medicamentos y que puede llevar a la muerte por obstrucción intestinal [51].

3) ¿Qué ensayos se publican con mayor frecuencia? Las compañías farmacéuticas tienen un incentivo natural para promover los resultados favorables de sus productos y minimizar los desfavorables. En la década de los 90s, un empleado de Wyeth borró archivos de la computadora eliminando la evidencia de que el fen-phen causaba enfermedad valvular cardíaca [52]. Un acercamiento más cauteloso (y popular) es simplemente no publicar este tipo de resultados.

La publicación selectiva de los resultados positivos y la no publicación de los resultados negativos se conoce como sesgo de publicación. La mejor estimación que tenemos es que la mitad de los ensayos clínicos que se finalizan nunca se publican en revistas académicas, y algunos de estos ensayos ni siquiera han sido registrados [53]. El sesgo de publicación existe tanto para los ensayos de la industria como para los que no están patrocinados por la industria, y afecta a los ensayos de cualquier tamaño [54]. Esto distorsiona significativamente la evidencia.

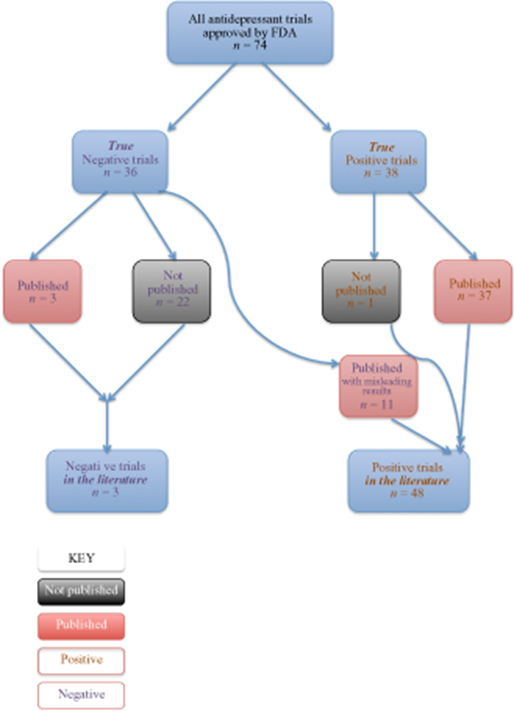

Centrándose específicamente en los antidepresivos, Turner et al. intentaron responder a la pregunta “¿Con qué precisión la literatura informa a la comunidad médica sobre la eficacia de un tratamiento?” [55]. Examinaron todos los ensayos con antidepresivos completados y registrados en la FDA (n = 74) y utilizaron la ley de libertad de información (Freedom of Information Act) para obtener la información completa de resultados, porque una tercera parte de los estudios no se habían publicado. En 38 ensayos, el antidepresivo estudiado fue más eficaz que el comparador (placebo u otro tratamiento activo). Vamos a catalogar a estos 38 ensayos como “positivos”. Otros 36 ensayos fueron “negativos”, es decir los antidepresivos estudiados no fueron más efectivos. Luego los investigadores examinaron el destino de estos ensayos. El que los ensayos fueran positivos o negativos se relacionaba fuertemente con la probabilidad de su publicación. Treinta y siete de los 38 ensayos con resultados positivos fueron publicados. Sin embargo, de los estudios negativos sólo tres fueron publicados adecuadamente. Veintidós no fueron publicados en absoluto y 11 fueron publicados en forma distorsionada, falsamente transmitiendo un resultado positivo. Esto se representa en la figura 1.

En resumen, en los artículos que el prescriptor puede acceder, el 94 % de los ensayos con antidepresivos muestran resultados positivos. Sin embargo, en la realidad sólo el 51 % de los ensayos registrados en la base de datos de la FDA fueron positivos, lo que resulta en una sobreestimación del tamaño del efecto de 32% [54].

Este es el único estudio sobre el que presentamos información detallada, por lo que se nos puede acusar de haber seleccionado un ejemplo excepcional para apoyar nuestra tesis, lo que nos convertiría en culpables de exactamente el mismo sesgo que estamos atacando. Sin embargo, este no es el caso. Hay una gran cantidad de evidencia, incluyendo varias revisiones sistemáticas, que muestran una fuerte evidencia de sesgo de publicación [36, 52, 56, 57]. Tres revisiones sistemáticas que examinan todos los estudios publicados – una tarea muy ambiciosa – encontraron que los estudios financiados por la industria presentaban resultados positivos con entre dos y cuatro veces mayor frecuencia que los estudios patrocinados por organismos independientes [36, 52, 55].

Aunque la MBE condena el sesgo de publicación y se esfuerza para identificarlo, no se puede hacer de forma muy precisa. Hay numerosos métodos disponibles pero ninguno puede identificar o descartar el sesgo de selección en su totalidad [54, 58-61]. Estos métodos (como los gráficos en embudo) se utilizan al hacer revisiones sistemáticas. También se trazan los resultados de todos los estudios disponibles y se utilizan modelos estadísticos para detectar lagunas. Estas técnicas son útiles, pero se asemejan a las ambulancias parcialmente equipadas esperando en el fondo de un precipicio.

4) ¿Cómo se identifican los estudios cuyas conclusiones se desacreditan? La evidencia defectuosa persiste. Los ensayos aleatorios sesgados no se etiquetan claramente como tales cuando se desacreditan. Una vez que los documentos entran en la literatura electrónica allí permanecen. No hay bibliotecarios cyber vigilantes que estampen un sello de “desacreditado” sobre ellos si son refutados con posterioridad, y pueden continuar induciendo a error. Si un médico hace una búsqueda por palabras clave, el ensayo aleatorio desacreditado puede ser el primero en aparecer sin que se identifiquen sus defectos. Incluso los críticos informados pueden ser engañados. Por ejemplo, Tatsioni et al. encontraron que el 50 % de las opiniones académicas seguían basándose en un ensayo clínico desacreditado que apoyaba un tratamiento (vitamina E para la enfermedad cardiaca) cinco años después de haber sido convincentemente demostrado que la terapia era ineficaz [62].

Discusión

Contando sus propios votos. La evidencia que hemos presentado indica que los ensayos deberían realizarse por organismos independientes.

El sentido común sugiere lo mismo. Imagínese si el gobierno propusiera la disolución de la comisión electoral para permitir que los propios políticos contaran sus propios votos. No sería aceptable por varias razones. Los políticos no son objetivos. Ellos han invertido tiempo y dinero en la campaña. Ellos creen en su partido. Ellos quieren ganar. El político menos honesto podría fabricar resultados. El más honesto podría abordar la tarea con sinceridad, pero ser influenciado subconscientemente y basándose en las anotaciones evaluar las papeletas incompletas como válidas. Por estas razones válidas, los resultados no serían aceptados, por lo que sería una pérdida de tiempo y dinero. Si este es el caso ¿Por qué se acepta el “el recuento de votos” que hace la industria sobre la eficacia de sus propios productos? Y no necesitamos un experimento mental para explorar si los resultados podrían estar sesgados. Experimentos reales ya lo han demostrado en repetidas ocasiones.

El autofinanciamiento como falso ahorro. Se podría objetar señalando que los ensayos aleatorios son muy caros. Se podría haber llegado a pensar que los ensayos aleatorios financiados por la industria representaban una feliz coincidencia entre los intereses comerciales y el bien público. Sin embargo, esto ha sido un falso ahorro. No sólo los costos de investigación efectuados por la industria se han recuperado a través de la financiación pública [63] sino que la evidencia resultante no es ni sólida ni confiable. Por otra parte, ya que los pacientes terminan pagando por los tratamientos (ya sea a través de impuestos, pólizas de seguros o de su bolsillo), el método menos sesgado para la evaluación de los tratamientos debería ser el que más le interesara. Ciertamente, lo que hemos escrito aquí sugiere que, a largo plazo, los pacientes se ahorrarían dinero si los ensayos fueran independientes.

La industria no es la única sesgada. Uno podría argumentar que es injusto condenar a la industria por ser parcial cuando todos los seres humanos tienen prejuicios. Sería ingenuo pensar que los ensayos financiados con fondos públicos estarían libres de prejuicios. Este argumento es totalmente válido y cuando se presenta evidencia acerca de otros sesgos debemos ser conscientes de ello, pero no es una excusa válida para justificar la falta de respuesta a los grandes sesgos de los ensayos financiados por la industria que conocemos en la actualidad.

¿Si tuviéramos mejor evidencia, tendríamos mejor información sobre la efectividad de la MBE? Nuestro argumento en relación con el desempeño de la MBE no es un argumento “de principios” sino contingente. Nuestra creencia es que si tuviéramos ensayos aleatorios imparciales tendríamos una mejor base de evidencia que, de aplicarse, debería dar lugar a beneficios para la salud tangibles y medibles. Aunque se trata de una cuestión especulativa (es posible que incluso con evidencia del todo imparcial, la MBE no se tradujera en beneficios demostrables para la población), es una hipótesis que vale la pena explorar. Abajo ofrecemos posibles soluciones a la naturaleza sesgada de los ensayos aleatorios financiados por la industria.

Hacia una solución. Hay mucha polémica sobre los problemas de las grandes farmacéuticas y se pide que haya mejor rendición de cuentas y regulación del sector. Apoyamos estos enfoques, pero los consideramos insuficientes. Es ingenuo pensar que podemos evitar que los intereses creados introduzcan sesgos. Los políticos no pueden contabilizar sus votos y en el deporte hay que depender de los árbitros, no pueden ser los jugadores los que se encarguen de poner las sanciones. ¿En qué estábamos pensando al asumir que la industria sería capaz de proporcionar evidencia sobre las intervenciones de salud que han desarrollado, en las que creen y de las que quieren beneficiarse? Tenemos que reconocer este sesgo inherente y tomar medidas contra él.

Está más allá del alcance de este artículo discutir soluciones prácticas con gran detalle, sin embargo, hacemos las siguientes sugerencias:

Las cuatro primeras propuestas no son nuevas. Sin embargo, modificar formalmente los sistemas de ranking de la evidencia rebajando de manera explícita la investigación con el sesgo del conflicto de interés no parece haber sido previamente examinado por el movimiento de la MBE. Esto sería un paso sencillo y fácil de implementar que puede facilitar la transición de la MBE “per se” a una situación en la que no toda la evidencia tenga la misma credibilidad y donde se reconozca que el sesgo de financiación es persuasivo y causa errores.

Conclusión

Hemos demostrado que los ensayos desfavorables se quedan con frecuencia sin publicar y no están disponibles para los médicos y pacientes. A través de los procesos de publicación selectiva y la manipulación del diseño del estudio, los estudios patrocinados por la industria tienden a ser favorables a sus productos. En pocas palabras, la evidencia patrocinada por la industria es incompleta y está sesgada. La mayoría de los estudios de intervención son patrocinados por la industria. Esto significa que la evidencia de muchas intervenciones es incompleta y está sesgada. Como resultado, los pacientes pueden recibir tratamientos menos eficaces, perjudiciales o más caros. Hemos propuesto algunas soluciones, incluyendo que el movimiento MBE rebaje explícitamente la calidad de toda la investigación producida por los que tienen un interés particular en los resultados.

Referencias